Une équipe de chercheurs du Laboratoire des sciences de l'éducation de l'Université Grenoble Alpes et du département d’informatique de l'Ecole polytechnique de Bucarest* a conçu et programmé un premier prototype d’un logiciel, ReaderBench, capable d’identifier les stratégies de lecture d’élèves d’école primaire ou de collège et d’évaluer la complexité de textes donnés à lire.

Une équipe de chercheurs du Laboratoire des sciences de l'éducation de l'Université Grenoble Alpes et du département d’informatique de l'Ecole polytechnique de Bucarest* a conçu et programmé un premier prototype d’un logiciel, ReaderBench, capable d’identifier les stratégies de lecture d’élèves d’école primaire ou de collège et d’évaluer la complexité de textes donnés à lire.

L’utilisation de stratégies pendant la lecture est un facteur important de la compréhension chez les adultes, comme chez les enfants (1). Ces stratégies désignent la capacité qu’ont les lecteurs d’exercer une veille attentive sur ce qu’ils comprennent au fur et à mesure de leur lecture, et de mettre œuvre des procédures de régulation en cas de difficulté. Recueillies par les explications à haute voix des élèves pendant la lecture, ces stratégies peuvent être catégorisées de la manière suivante : régulation de la compréhension (« Je crois que j’ai compris que le héros hésite à blesser le monstre. »), paraphrase (répétition presque à l’identique d’une proposition), élaboration (construction d’une nouvelle connaissance à partir du texte), prédiction (« Le héros va se marier avec la princesse ») et mise en relation, ou bridging (« Mais le héros s’est déjà battu avec le monstre au tout début »).

Le premier but recherché au travers de l’outil ReaderBench est d’analyser automatiquement l’emploi de ces stratégies à partir des explications des élèves (transcrites de l’oral) en utilisant des méthodes de traitement automatique des langues comme l’« analyse sémantique latente » (2).

Ainsi, l’outil ReaderBench a été conçu afin de permettre des mesures de comparaison sémantique entre les paragraphes du texte à lire et les explications orales retranscrites du lecteur révélatrices de ses stratégies de lecture. L’élève et l’enseignant peuvent ainsi avoir une idée précise du niveau de compréhension du texte lu.

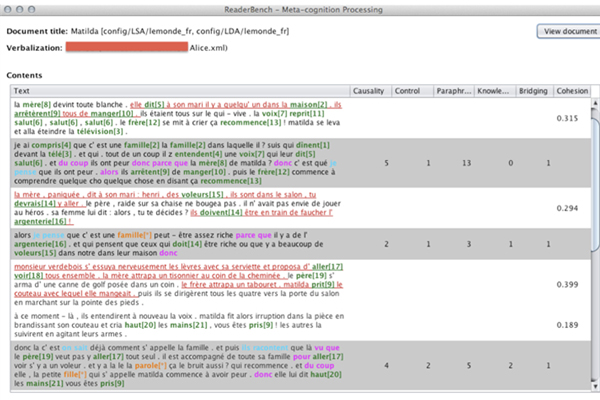

Sur l’interface de Readerbench, les stratégies de lecture sont représentées par des couleurs (voir Figure 1, où figurent sur fond blanc le texte lu et sur fond gris les explications consécutives à leur lecture) : la régulation en bleu, la paraphrase en vert suivi entre crochets par un numéro d’index référant aux mots du texte lu, l’élaboration en orange suivie par un astérisque, signalant un mot inféré et non présent dans le segment lu (comme famille), et la mise en relation en rouge souligné (relation entre phrases du texte lu).

L’analyse de cette représentation peut par exemple permettre de révéler un nombre trop important de paraphrases (répétition de portions de texte lu sans compréhension profonde), alors que des élaborations ou des mises en relation seraient des indices d’une compréhension de plus haut niveau.

Figure 1 : analyse des stratégies de lecture et de la cohésion textuelle dans ReaderBench. Les 5 premières colonnes indiquent, par explication, la fréquence de chaque stratégie. La dernière colonne indique la cohésion entre l’explication (fond gris) et le paragraphe du texte correspondant (fond blanc). Dans l’exemple, la dernière explication a une cohésion la plus grande avec l’avant-dernier paragraphe lu.

Une autre fonction de ReaderBench est l’évaluation de la complexité des textes analysés. Cette évaluation est une tâche très difficile compte tenu de la difficulté pour un enseignant de se mettre à la place du niveau de vocabulaire et de compréhension d’un élève et, compte tenu également de la difficulté à comparer un ensemble de textes selon ce paramètre. Néanmoins, pouvoir sélectionner du matériel de lecture qui soit accessible à un niveau scolaire donné est très important pour l’enseignant.

Il existe déjà des moyens, bien connus et plutôt fiables, pour l’évaluation de cette complexité textuelle (les formules de lisibilité par exemple) mais elles se fondent en général sur des niveaux très bas du texte (nombre moyen de syllabes par mot, pourcentage de mots très fréquents dans la langue, etc.). Pour cette raison, l’approche qui a été privilégiée dans ReaderBench est une analyse agrégeant un grand nombre de mesures de niveaux très différents (des formules classiques de lisibilité, les techniques issues de l’évaluation automatique de copies, ainsi que des facteurs morpho-syntaxiques et sémantiques). De plus, les résultats de cette analyse font l’objet d’une classification automatique à partir d’un ensemble de textes préalablement classés par un expert humain.

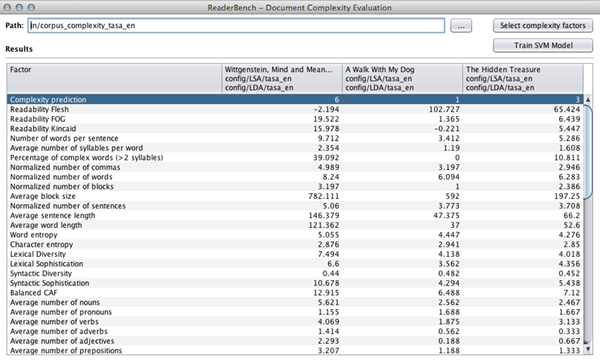

La Figure 2 ci-dessous, issue du logiciel ReaderBench, présente des informations suite à l’analyse de la complexité textuelle de trois documents ; le choix des paramètres et des mesures pouvant être librement fait par l’enseignant.

Figure 2 : Analyse de la complexité textuelle de trois documents dans ReaderBench (pour l’instant, ne fonctionne que pour l’anglais). La première ligne indique la classe de complexité (croissante, entre 1 et 6) de chaque document. Les lignes représentent chacune des mesures utilisées et leurs valeurs pour chaque texte. Le texte sur Wittgenstein est donc le plus complexe des trois.

* L’équipe de chercheurs se compose de Maryse Bianco et Philippe Dessus du Laboratoire des sciences de l’éducation, Univ. Grenoble Alpes ; Mihai Dascalu et Stefan Trausan-Matu, du département d’informatique de l’Université Polytechnique de Bucarest, Roumanie ; et d’Aurélie Nardy, du LIDILEM et du LSE, Univ. Grenoble Alpes. ReaderBench a été programmé par Mihai Dascalu.

Notes :

(1) Voir l’article « Vers un tuteur informatique pour aider dans l’apprentissage de la lecture » publié en septembre 2012 sur le site du Pôle Grenoble Cognition.

(2) L’analyse sémantique latente (LSA, Latent Semantic Analysis) est un procédé de traitement des langues naturelles, qui permet d'établir des relations sémantiques entre les termes d’un document ou de plusieurs documents, en construisant des « concepts » liés aux documents et aux termes. (http://lsa.colorado.edu/). Voir notamment les travaux de Danielle McNamara, Université de l’Etat d’Arizona, USA.

Les résultats de cette recherche ont fait l’objet des publications suivantes :

Dascalu, M., Dessus, P., Trausan-Matu, S., Bianco, M. & Nardy, A. (2013, 9-13 July). ReaderBench, an environment for analyzing text complexity and reading strategies. In 16th Int. Conf. on Artificial Intelligence in Education (AIED 2013). Memphis.

Dascalu, M., Trausan-Matu, S., & Dessus, P. (2012). Towards an integrated approach for evaluating textual complexity for learning purposes. In E. Popescu, R. Klamma, H. Leung, & M. Specht (Eds.), Advances in Web-based Learning (ICWL 2012) (pp. 268–278). New York: Springer, LNCS 7558.

Nardy, A., Bianco, M., Toffa, F., Rémond, M. & Dessus, P. (sous presse). Contrôle et régulation de la compréhension : L'acquisition de stratégies de 8 à 11 ans. In J. David & C. Royer (Eds.), L'apprentissage de la lecture : convergences, innovations, perspectives. Berne : Peter Lang.

Dascalu, M., Dessus, P., Bianco, M., Loiseau, M. & Trausan-Matu, S. (soumis à publication). L’apport du TAL dans des environnements favorisant l’apprentissage auto-régulé.

Contacts chercheurs :

Cette adresse e-mail est protégée contre les robots spammeurs. Vous devez activer le JavaScript pour la visualiser., laboratoire des sciences de l'éducation, univ. Grenoble Alpes

Cette adresse e-mail est protégée contre les robots spammeurs. Vous devez activer le JavaScript pour la visualiser., laboratoire des sciences de l'éducation, univ. Grenoble Alpes

Cette recherche est développée dans le cadre du projet DEVCOMP (responsable Maryse Bianco, UPMF), financé par l'Agence nationale de la recherche (ANR), du côté français, et le projet 64207 ERRIC – Empowering Romanian Research on Intelligent Information Technologies/FP7-REGPOT-2010-1 et une allocation de recherche doctorale POSDRU/107/1.5/S/76909 Harnessing human capital in research through doctoral scholarships (ValueDoc).